對數據集進行異常檢測及比較簡介

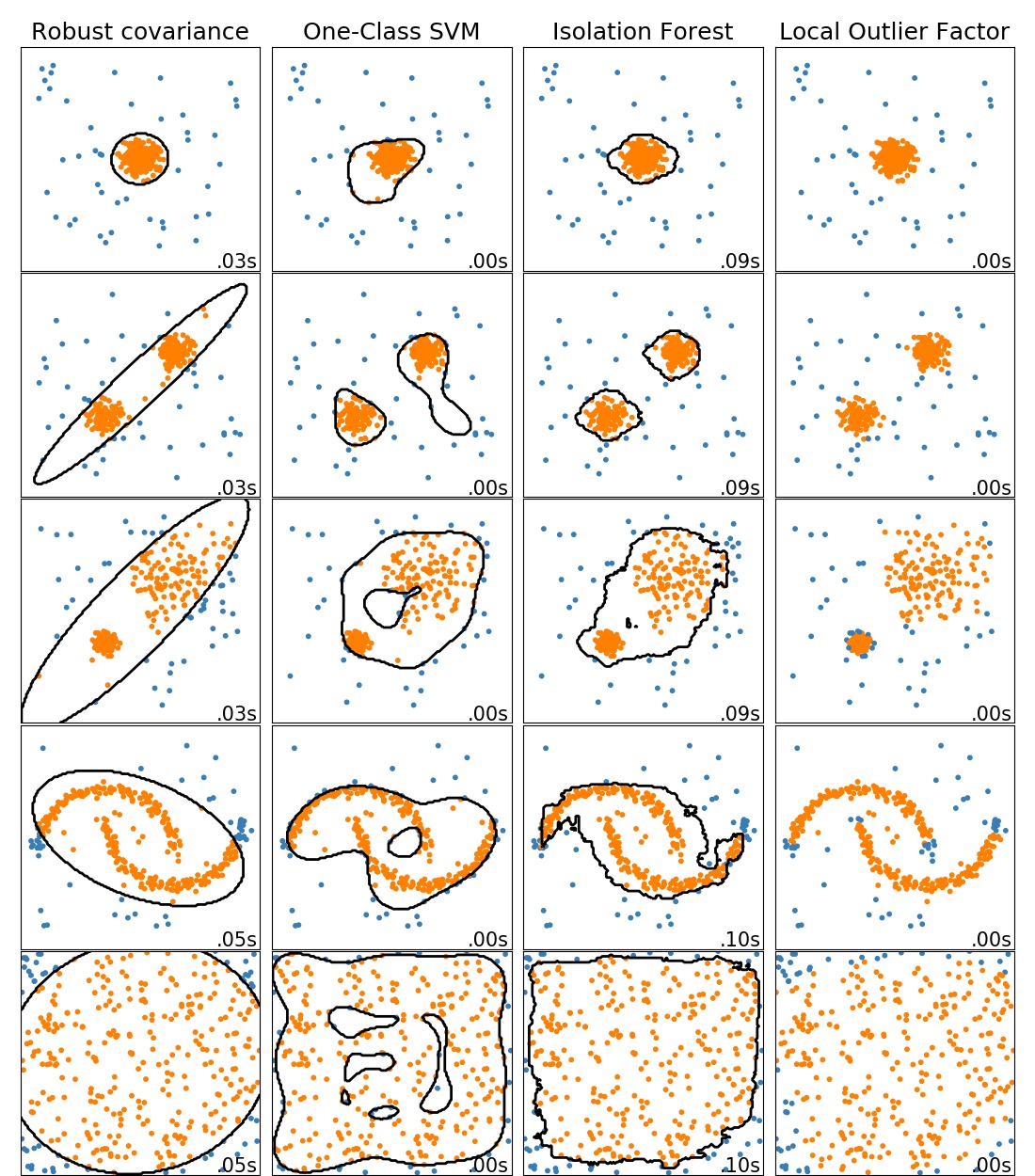

此示例顯示了2D數據集上不同異常檢測算法的特征。數據集包含一種或兩種模式(高密度區域),以說明算法處理多模式數據的能力。

示例中有5個數據集,對於每個數據集,將生成15%的樣本作為隨機均勻噪聲。該比例是為OneClassSVM的nu參數和其他異常值檢測算法的汙染參數提供的值。離群值和離群值之間的決策邊界以黑色顯示,但局部離群值因子(LOF)除外,因為當用於離群值檢測時,它沒有適用於新數據的預測方法。

sklearn.svm.OneClassSVM已知對異常值敏感,因此對於異常值檢測效果不佳。當訓練集不受異常值汙染時,此估計器最適合新穎性檢測;而且,在高維空間中檢測異常值,或者不對基礎數據的分布進行任何假設都是非常具有挑戰性的,而One-class SVM在這些情況下可能會得到有用的結果,如果超參數設置合適的話。

sklearn.covariance.EllipticEnvelope假定數據為高斯分布並學習一個橢圓。因此,當數據不是高斯分布的單峰時,性能會降低。但是請注意,這個模型估計對異常值具有魯棒性。

sklearn.ensemble.IsolationForest和sklearn.neighbors.LocalOutlierFactor對於多模(multi-modal)數據集,效果似乎還不錯。sklearn.neighbors.LocalOutlierFactor相對其他模型的優勢在第3個數據集有展示,其中兩種模式的密度不同。 LOF的局部特性解釋了此優勢,也就是它僅將一個樣本的異常評分與其鄰居的評分進行比較。

對於第5個數據集,很難說一個樣本比另一個樣本異常得多,因為它們均勻分布在超立方體中。除了sklearn.svm.OneClassSVM有點不合適,其他所有估算器都針對這種情況給出了不錯的解決方案。在這種情況下,明智的做法是仔細觀察樣本的異常分數,因為好的模型估計器應該為所有樣本分配相似的分數。

另外,此處已手動選擇了模型的參數,但實際上需要對其進行進一步調整優化。在沒有標記數據的情況下,是非監督學習問題,因此針對不同的實際情況選擇模型可能是一個很大的挑戰。

注意:盡管這些示例給出了有關算法的一些直覺,但這種直覺可能不適用於非常高維的數據。

代碼實現[Python]

# -*- coding: utf-8 -*-

# Author: Alexandre Gramfort

# Albert Thomas

# License: BSD 3 clause

import time

import numpy as np

import matplotlib

import matplotlib.pyplot as plt

from sklearn import svm

from sklearn.datasets import make_moons, make_blobs

from sklearn.covariance import EllipticEnvelope

from sklearn.ensemble import IsolationForest

from sklearn.neighbors import LocalOutlierFactor

print(__doc__)

matplotlib.rcParams['contour.negative_linestyle'] = 'solid'

# Example settings

n_samples = 300

outliers_fraction = 0.15

n_outliers = int(outliers_fraction * n_samples)

n_inliers = n_samples - n_outliers

# define outlier/anomaly detection methods to be compared

anomaly_algorithms = [

("Robust covariance", EllipticEnvelope(contamination=outliers_fraction)),

("One-Class SVM", svm.OneClassSVM(nu=outliers_fraction, kernel="rbf",

gamma=0.1)),

("Isolation Forest", IsolationForest(behaviour='new',

contamination=outliers_fraction,

random_state=42)),

("Local Outlier Factor", LocalOutlierFactor(

n_neighbors=35, contamination=outliers_fraction))]

# 定義數據集,這個給定了5個數據集(Define datasets)

blobs_params = dict(random_state=0, n_samples=n_inliers, n_features=2)

datasets = [

make_blobs(centers=[[0, 0], [0, 0]], cluster_std=0.5,

**blobs_params)[0],

make_blobs(centers=[[2, 2], [-2, -2]], cluster_std=[0.5, 0.5],

**blobs_params)[0],

make_blobs(centers=[[2, 2], [-2, -2]], cluster_std=[1.5, .3],

**blobs_params)[0],

4. * (make_moons(n_samples=n_samples, noise=.05, random_state=0)[0] -

np.array([0.5, 0.25])),

14. * (np.random.RandomState(42).rand(n_samples, 2) - 0.5)]

# 在給定的設置上比較不同分類器模型(Compare given classifiers under given settings)

xx, yy = np.meshgrid(np.linspace(-7, 7, 150),

np.linspace(-7, 7, 150))

plt.figure(figsize=(len(anomaly_algorithms) * 2 + 3, 12.5))

plt.subplots_adjust(left=.02, right=.98, bottom=.001, top=.96, wspace=.05,

hspace=.01)

plot_num = 1

rng = np.random.RandomState(42)

for i_dataset, X in enumerate(datasets):

# Add outliers

X = np.concatenate([X, rng.uniform(low=-6, high=6,

size=(n_outliers, 2))], axis=0)

for name, algorithm in anomaly_algorithms:

t0 = time.time()

algorithm.fit(X)

t1 = time.time()

plt.subplot(len(datasets), len(anomaly_algorithms), plot_num)

if i_dataset == 0:

plt.title(name, size=18)

# fit the data and tag outliers

if name == "Local Outlier Factor":

y_pred = algorithm.fit_predict(X)

else:

y_pred = algorithm.fit(X).predict(X)

# plot the levels lines and the points

if name != "Local Outlier Factor": # LOF does not implement predict

Z = algorithm.predict(np.c_[xx.ravel(), yy.ravel()])

Z = Z.reshape(xx.shape)

plt.contour(xx, yy, Z, levels=[0], linewidths=2, colors='black')

colors = np.array(['#377eb8', '#ff7f00'])

plt.scatter(X[:, 0], X[:, 1], s=10, color=colors[(y_pred + 1) // 2])

plt.xlim(-7, 7)

plt.ylim(-7, 7)

plt.xticks(())

plt.yticks(())

plt.text(.99, .01, ('%.2fs' % (t1 - t0)).lstrip('0'),

transform=plt.gca().transAxes, size=15,

horizontalalignment='right')

plot_num += 1

plt.show()

代碼執行

代碼運行時間大約:0分3.491秒。

運行代碼輸出的圖片內容如下:

源碼下載

- Python版源碼文件: plot_anomaly_comparison.py

- Jupyter Notebook版源碼文件: plot_anomaly_comparison.ipynb