是否可以對Tensorflow的不同層使用不同的學習率?

我正在嘗試修改預訓練模型並將其用於其他任務。我想要的是加快對新添加的層的訓練,並使受過訓練的層保持較低的學習率,以防止它們變形。例如,我有一個5個卷積層的預訓練模型,然後,我添加了一個新的轉換層並對其進行微調。前5層的學習率為0.00001,後5層的學習率為0.001。如何實現這一目標?

相似問題:

- Tensorflow按網絡分層設置學習速率(learning rate)。

- Tensorflow給每一層分別設置學習速率。

方案1:

使用2個優化器可以很容易地實現它:

var_list1 = [variables from first 5 layers]

var_list2 = [the rest of variables]

train_op1 = GradientDescentOptimizer(0.00001).minimize(loss, var_list=var_list1)

train_op2 = GradientDescentOptimizer(0.0001).minimize(loss, var_list=var_list2)

train_op = tf.group(train_op1, train_op2)

此實現的一個缺點是,它在優化器內部兩次計算tf.gradients(。),因此就執行速度而言可能不是最佳的。可以通過顯式調用tf.gradients(.),將列表分成2個並將相應的梯度傳遞給兩個優化器來緩解這種情況。

相關問題:Holding variables constant during optimizer

改進版:添加了更有效但也有更多代碼的實現:

var_list1 = [variables from first 5 layers]

var_list2 = [the rest of variables]

opt1 = tf.train.GradientDescentOptimizer(0.00001)

opt2 = tf.train.GradientDescentOptimizer(0.0001)

grads = tf.gradients(loss, var_list1 + var_list2)

grads1 = grads[:len(var_list1)]

grads2 = grads[len(var_list1):]

tran_op1 = opt1.apply_gradients(zip(grads1, var_list1))

train_op2 = opt2.apply_gradients(zip(grads2, var_list2))

train_op = tf.group(train_op1, train_op2)

可以使用tf.trainable_variables()獲取所有訓練變量並決定從中選擇。不同之處在於,在第一個實現中,tf.gradients(.)在優化器中被兩次調用。這可能會導致執行一些冗餘操作(例如,第一層上的梯度可以將某些計算重新用於後續層的梯度)。

方案2

下麵的方法隻對GradientDescentOptimizer有效(除了Rafal的方法外,您可以使用Optimizer的compute_gradients和apply_gradients接口)。例子如下,在下麵這個實驗網絡中,我將第二個參數的學習率提高了2倍

x = tf.Variable(tf.ones([]))

y = tf.Variable(tf.zeros([]))

loss = tf.square(x-y)

global_step = tf.Variable(0, name="global_step", trainable=False)

opt = tf.GradientDescentOptimizer(learning_rate=0.1)

grads_and_vars = opt.compute_gradients(loss, [x, y])

ygrad, _ = grads_and_vars[1]

train_op = opt.apply_gradients([grads_and_vars[0], (ygrad*2, y)], global_step=global_step)

init_op = tf.initialize_all_variables()

sess = tf.Session()

sess.run(init_op)

for i in range(5):

sess.run([train_op, loss, global_step])

print sess.run([x, y])

可以看輸出

[0.80000001, 0.40000001]

[0.72000003, 0.56]

[0.68800002, 0.62400001]

[0.67520005, 0.64960003]

[0.67008007, 0.65984005]

方案3[推薦]

Tensorflow 1.7引入了tf.custom_gradient,該方法極大地簡化了設置學習速率乘數的方式,該方式現已與任何優化器(包括那些累積梯度統計數據的優化器)兼容。例如,

import tensorflow as tf

def lr_mult(alpha):

@tf.custom_gradient

def _lr_mult(x):

def grad(dy):

return dy * alpha * tf.ones_like(x)

return x, grad

return _lr_mult

x0 = tf.Variable(1.)

x1 = tf.Variable(1.)

loss = tf.square(x0) + tf.square(lr_mult(0.1)(x1))

step = tf.train.GradientDescentOptimizer(learning_rate=0.1).minimize(loss)

sess = tf.InteractiveSession()

tf.global_variables_initializer().run()

tf.local_variables_initializer().run()

for _ in range(5):

sess.run([step])

print(sess.run([x0, x1, loss]))

擴展閱讀

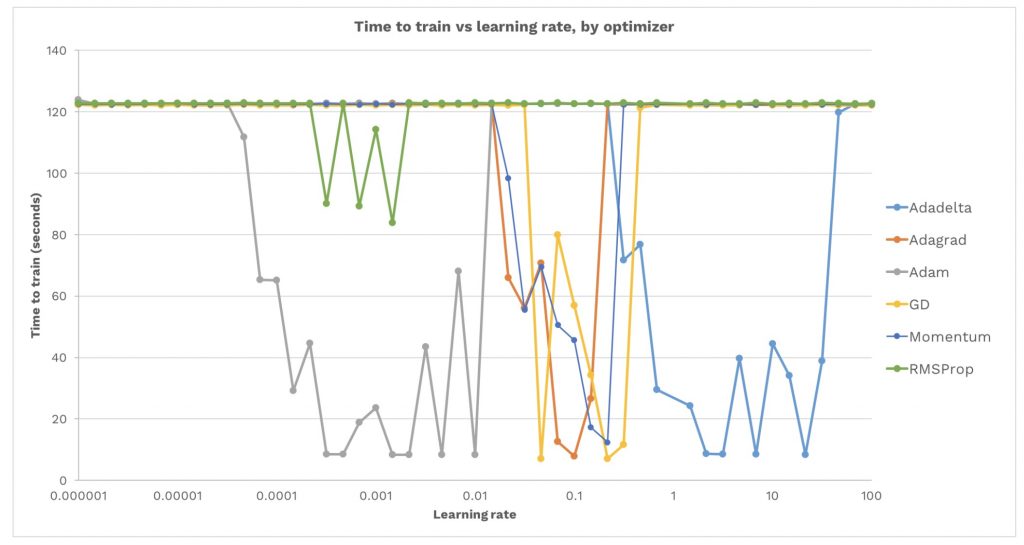

如何為GradientDescentOptimizer設置自適應學習率?

參考資料